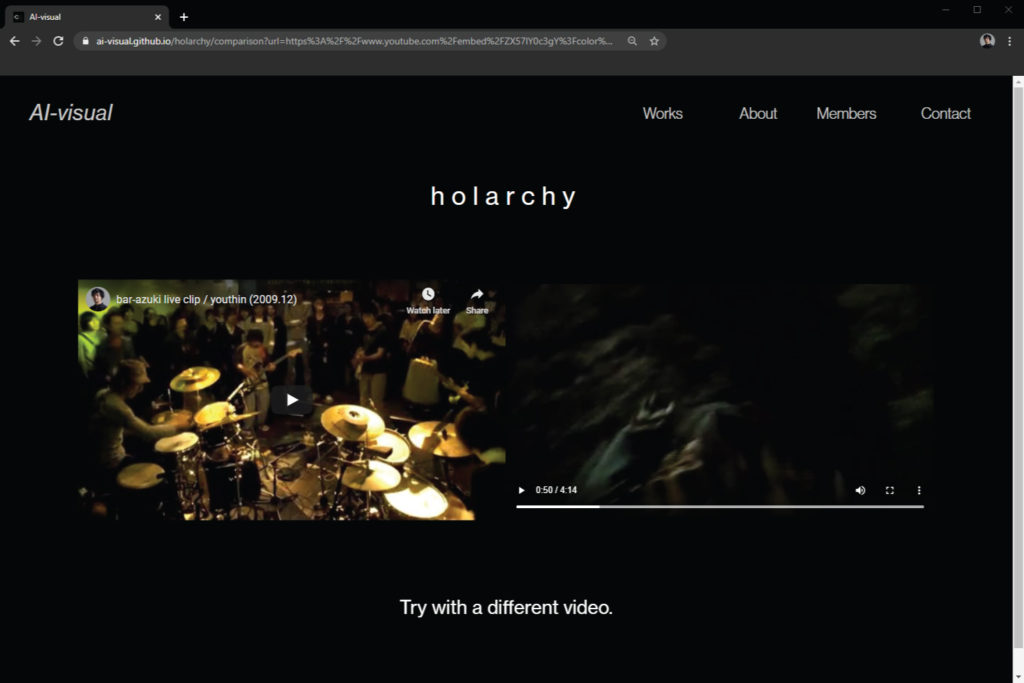

https://ai-visual.github.io/holarchy/

ABOUT

This work is an online installation that creates a new audio-visual using automatic video selection with deep learning.

Video expression in the audio-visual and DJ+VJ, where sound and images coexist together, has been based on sampling methods by combining clips that already exist, generative methods that are computed in real time by computer, and the use of the sound of the phenomenon and the situation itself.Its visual effects have extended music and given it new meanings.

However, in all of these methods, the selection of the video and the program itself was premised on the artist’s arbitrary decision to match the music.

This work is an online installation that eliminates the arbitrariness of the artist, creating a new audio-visual work by comparing in the same space the feature of the music and the feature of a number of images selected by the artist beforehand and selecting them automatically. In this work, the sounds of the youtube video selected by the viewer are separated every few seconds, and the closest video is selected by comparing these features with the features of countless short clips of movies and videos prepared in advance in the same space.

This video selection method reconstructs the mapping relationship that artists have constructed so far between video and sound using deep learning, and suggests the possibility of possible correspondences. In addition, unconnected scenes from different films and images that have never been connected before become a single image, and emerge as a whole, and the viewer finds a story in the relationship between them.

With this work, audio-visual and DJ+VJ expression is freed from the arbitrary decision, and a new perspective is given to the artists.

本作は、ディープラーニングによる映像の自動選択を用いて、新たなAudio-Visualを生み出すオンラインインスタレーションです。

音と映像が共存するオーディオ・ビジュアルやDJ+VJにおける映像表現は、既に存在するクリップを組み合わせたサンプリング手法や、コンピュータでリアルタイムに計算される生成手法、現象や状況そのものの音を利用したものなどがあり、その視覚効果は音楽を拡張し、新たな意味を与えてきました。しかし、これらの方法のいずれにおいても、映像やプログラム自体の選択は、音楽に合わせたアーティストの恣意的な判断が前提となっていました。

本作は、アーティストの恣意性を排除し、音楽の特徴と、あらかじめアーティストが選択した複数の映像の特徴を同一空間内で比較し、自動的に選択することで、新たな視聴覚作品を生み出すオンライン・インスタレーションです。本作品では、視聴者が選択したYouTube動画の音を数秒ごとに分離し、これらの特徴と、予め同一空間内に用意された無数のショートクリップの映画や動画の特徴とを比較して、最も近い動画を選択します。

この映像選択法は、これまでアーティストが構築してきた映像と音のマッピング関係をディープラーニングを用いて再構築し、対応関係の可能性を示唆するものでもあります。また、これまで繋がり得なかった異なる映画や映像のシーンが一つのイメージとなって浮かび上がり、鑑賞者はそれらの関係性の中に物語を見出します。さらに、Audio-VisualやDJ+VJの表現が恣意的な判断から解放されることで、アーティストにも新たな視点が与えられることを期待します。

DATE CREATED

April 20th, 2020.

CREDIT

Direction: Scott Allen

Deep learning: Yusuke Yamada

UI: Reo Anzai

Front-end: Santa Naruse

Tech support: Aina Ono

Technical advice: Nao Tokui

CONFERENCE

SIGGRAPH ASIA 2020 ART GALLERY